Terobosan Baru! OpenAI Siapkan Tim Khusus untuk Cegah Risiko AI yang Mengancam

Dalam dunia yang semakin bergantung pada kecerdasan buatan , OpenAI mengambil langkah besar dengan membentuk tim khusus. Tim ini bertugas untuk mengawasi dan mengevaluasi risiko yang mungkin timbul dari pengembangan AI tingkat tinggi. Langkah ini diambil untuk memastikan bahwa setiap teknologi yang dirilis aman bagi masyarakat.

Tim Siaga AI: Pengawal Keamanan Teknologi Masa Depan

Melalui sebuah postingan blog pada 18 Desember 2023, OpenAI mengumumkan pembentukan “Tim Siaga AI” yang akan berfungsi sebagai penghubung antara tim keamanan dan kebijakan. Tim ini akan meninjau laporan keamanan dan memberikan rekomendasi kepada eksekutif perusahaan serta dewan direksi.

Baca juga: Sam Altman Ungkap Rencana Besar untuk Revolusi OpenAI!

Dengan sistem semacam sistem checks-and-balances, OpenAI berkomitmen untuk mencegah “risiko bencana” yang mungkin ditimbulkan oleh model AI yang semakin canggih. Dewan direksi OpenAI kini memiliki wewenang untuk membatalkan keputusan yang berkaitan dengan keamanan AI.

Hal ini merupakan langkah baru yang memberikan dewan kekuatan untuk memastikan bahwa setiap pengembangan teknologi tidak akan membahayakan masyarakat. Keputusan ini diambil setelah serangkaian perubahan besar di OpenAI, termasuk pergantian CEO yang mengejutkan pada November lalu.

Kerangka Kerja Baru untuk AI yang Bertanggung Jawab

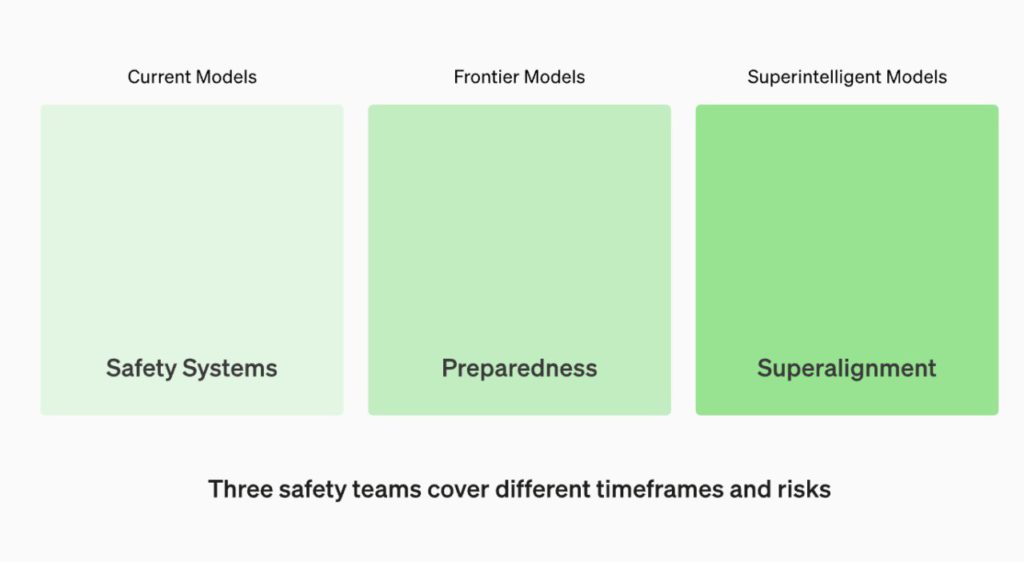

OpenAI tidak hanya membentuk tim baru, tetapi juga mengadopsi “Kerangka Kerja Kesiapan” yang baru. Kerangka kerja ini dirancang untuk melacak, mengevaluasi, meramalkan, dan melindungi dari risiko bencana yang mungkin ditimbulkan oleh model AI yang semakin kuat.

Tim “Superalignment” juga akan mengawasi pengembangan model-model “superintelligent”, yang masih berada dalam ranah teori. Setiap model yang dikembangkan akan dinilai berdasarkan empat kategori risiko: keamanan siber, persuasi (kebohongan dan disinformasi), otonomi model (bertindak sendiri), dan CBRN (ancaman kimia, biologi, radiologi, dan nuklir). Jika risiko dianggap kritis, pengembangan akan dihentikan, sementara risiko tinggi akan mencegah penyebaran teknologi tersebut.

Baca juga: Melalui Converge 2, OpenAI Siapkan Dana Investasi Senilai $1 Juta untuk Startup AI!

Transparansi dan Akuntabilitas: Kunci Kepercayaan Publik

OpenAI berjanji akan transparan dalam proses pengambilan keputusan terkait risiko AI. Jika terdapat masalah, pihak ketiga independen akan diajak untuk mengaudit teknologi dan memberikan umpan balik. Ini adalah bagian dari upaya OpenAI untuk membangun kepercayaan publik dan memastikan bahwa pengembangan AI berlangsung dengan tanggung jawab.

Meskipun OpenAI telah menetapkan kerangka kerja yang ketat, masih ada pertanyaan tentang seberapa efektif dewan direksi dalam menggunakan kekuatan vetonya. Transparansi dan akuntabilitas akan menjadi kunci untuk memastikan bahwa teknologi AI yang dikembangkan tidak hanya canggih, tetapi juga aman dan bertanggung jawab.

Pada akhirnya, langkah OpenAI dalam membentuk tim khusus dan memberikan kekuatan veto kepada dewan direksi menunjukkan keseriusan dalam menghadapi risiko AI. Ini merupakan langkah penting dalam perjalanan menuju pengembangan AI yang aman dan bertanggung jawab, yang pada akhirnya akan membawa manfaat bagi seluruh umat manusia.

Ikuti kami di Google News untuk mendapatkan berita-berita terbaru seputar crypto. Nyalakan notifikasi agar tidak ketinggalan beritanya.

*Disclaimer

Konten ini bertujuan memperkaya informasi pembaca. Selalu lakukan riset mandiri dan gunakan uang dingin sebelum berinvestasi. Segala aktivitas jual beli dan investasi aset crypto menjadi tanggung jawab pembaca.

Referensi:

- Cointelegraph. OpenAI Launches Preparedness Team for AI Safety, Gives Board Final Say. Diakses pada tanggal 20 Desember 2023

- SiliconANGLE. New OpenAI safety team will power block high-risk developments. Diakses pada tanggal 20 Desember 2023

- TechCrunch. OpenAI buffs safety team and gives board veto power on risky AI. Diakses pada tanggal 20 Desember 2023